Sam Altman 自信地表示,OpenAI 所开发的模型已经基本具备实现 AGI 的技术基础;而 François Chollet 却严厉批评这一说法是荒谬的,甚至称之为 “完全的胡言乱语”("clown shoes")。

François Chollet 并不是另一个无病呻吟的网友,相反,他是一名谷歌员工,多年为深度学习领域做出了重大研究贡献。事实上,他所发起建立的 ARC-AGI 在 2024 年 12 月,正式被 OpenAI 作为衡量其实验性 “o3” 模型性能的主要基准。

Chollet 的质疑并非毫无根据。在他看来,现有的人工智能模型虽然可以通过众多复杂的考试 —— 例如美国律师考试(LSAT)、高级生物学考试甚至侍酒师初级考试 —— 却并不意味着这些模型真正具备了智能。肖莱认为,AI 公司长期以来一直 “智识懒惰”,习惯用大量的记忆与训练数据来应付特定任务,而非真正理解并解决前所未见的问题。

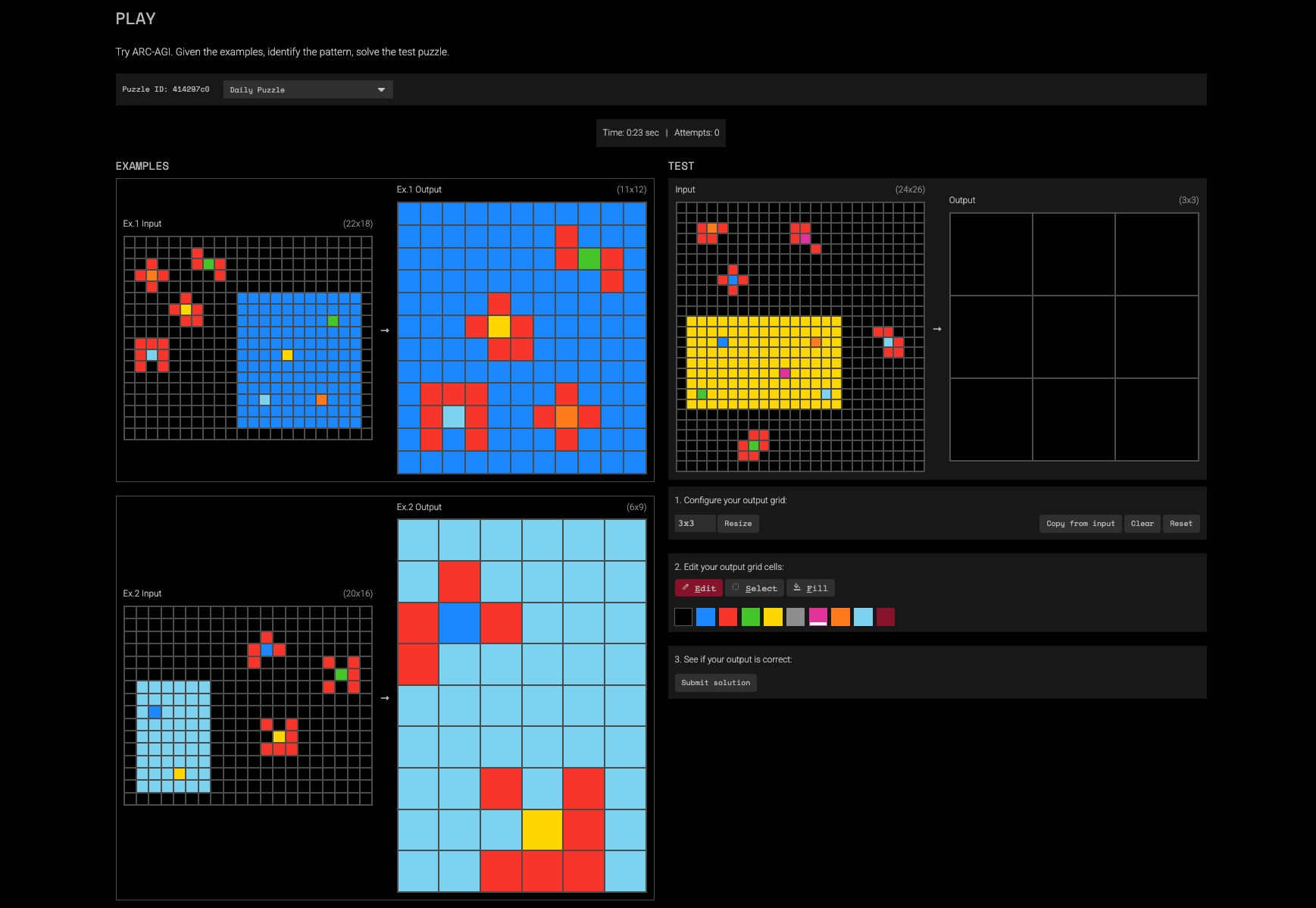

为验证 AI 的真正智能水平,Chollet 于 2019 年设计了 ARC-AGI 测试(注意,ChatGPT 发布是在 2022 年底)。这个测试看似简单,却真正考验了模型的流动智力,即快速学习和应对全新挑战的能力。ARC-AGI 要求测试者通过观察一系列颜色方块的排列规律,自行推导规则并完成接下来的图案拼接任务。这种考验抽象推理的任务,人类首次尝试便能取得约 60% 至 70% 的正确率,而初代的 GPT-3 模型得分却是惨淡的 0%。即使后来 OpenAI 宣称 “推理能力大幅增强” 的 GPT-4o 模型,也只达到 5% 的正确率。

这种长期的失败让 AI 业界开始重新审视自己的方向。OpenAI 在 2024 年末推出了名为 o3 的新型推理模型,这款模型以惊人的 87% 的正确率首次接近了人类在 ARC-AGI 上的表现,肖莱也称赞其为 “真正的突破”。但即使如此,他依旧保持谨慎与怀疑。他指出,这款模型解决问题的方式依旧是大规模穷举式的尝试,耗费了大量的时间和计算资源,每道题目需耗时约 14 分钟、花费大量资金。

为进一步探索 AI 的真正智能水平,肖莱随后发布了难度更高的 ARC-AGI-2。在这个新版本的测试中,人类依旧能取得约 60% 的成绩,但平均需花费 5 分钟以上才能解答。然而,之前表现不俗的 OpenAI 的 o1 和 o3 迷你版本在新测试中的得分急剧下降到 3% 甚至 2% 以下,其他顶级 AI 模型的表现则更为惨淡,仅约 1%。

通过这次升级的测试,肖莱进一步强调了他的核心观点:单纯提高 AI 模型的计算能力和训练数据规模,并不能真正使其拥有类似人类的智能。真正的智能应该体现在面对新问题时能迅速理解并灵活应对的能力,而非依靠暴力穷举或记忆。

尽管 OpenAI 等公司如今逐渐认可了肖莱的 ARC-AGI 测试,并开始用其衡量自身的进步,但实际上,这些公司的真正目标可能并非严格意义上的智能,而是 “有用性” 和商业价值。文章提到,微软与 OpenAI 甚至已经协议定义 “实现 AGI” 的标准为:“能创造大约 1000 亿美元利润的软件。” 这种定义显然更关注经济收益而非智能本质。

作者最后指出了一个更加根本的问题:真正的通用智能或许根本无法用任何单一测试或标准去定义和衡量。人类智能本身就是一个复杂、多样的综合体,包含了情感、意图、创造性和经验等因素。正如文章所述:“人类的认知多样性造就了辩论、创造与美感。” 如何去复制这种复杂多彩的人类智慧?而更重要的是,是否真的需要或者想要如此复制?

因此,通往 AGI 的旅程也许才刚刚开始,真正的挑战远非技术本身,而在于我们对智能的理解与定义是否能够真正把握其多样性与深度。

- 关于 ARC-AGI: 🔗 https://arcprize.org/arc-agi

- 想看看自己的的水平如何?来试试 ARC-AGI 测试: 🔗 https://arcprize.org/play